简介

本篇文章旨在介绍一个全面的“王中王资料大全料大全1”的内容整理和数据获取方案。我们将深入探讨如何通过程序化的方法来获取和管理这些数据,确保资料的完整性和可靠性。

资料的分类与特点

“王中王资料大全料大全1”涵盖了多个领域的知识与信息,包括但不限于经济、科技、教育、文化等领域。特点如下:

- 信息量大:包含了各个领域的海量信息数据。

- 实时更新:资料会根据最新的发展进行实时更新,确保信息的时效性。

- 多语种支持:提供多种语言版本,以满足不同用户的需要。

- 易于检索:通过智能检索系统快速定位所需资料。

数据获取的必要性

在这个信息爆炸的时代,获取和处理大量的数据变得尤为关键。这对于企业决策、学术研究、市场分析等都至关重要。数据获取的必要性包括:

- 提高决策速度:快速获取数据能帮助快速做出决策,抢占市场先机。

- 降低成本:程序化获取数据可以减少人工成本,提高效率。

- 数据分析:通过获取的大量数据可以进行深入的分析,发掘有用的信息。

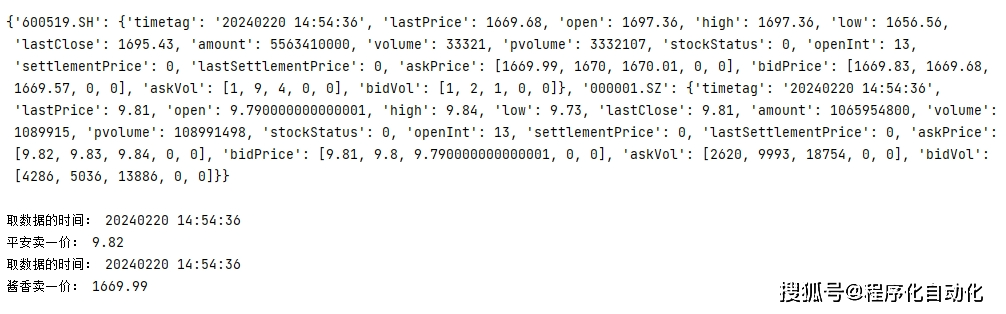

程序化的数据处理方法

程序化的数据处理方法涉及到以下几个关键步骤:

1. 数据抓取

使用爬虫技术从各大网站、数据库等源头获取数据。这需要遵循相应的法律法规,确保数据抓取的合法性。

2. 数据清洗

对抓取的数据进行预处理,包括去除无用信息、填充缺失值、识别和修正错误等,保证数据的质量和准确性。

3. 数据存储

将清洗后的数据存储到适合的数据仓库,便于后续的查询和分析。这可能包括关系型数据库、NoSQL数据库等存储解决方案。

4. 数据分析

运用数据分析工具(如Python的pandas, R语言等)对数据进行统计和分析,挖掘数据背后的信息和规律。

5. 数据可视化

将分析结果通过图表、仪表板等形式直观展示给用户,帮助用户快速了解数据的含义和趋势。

技术实现

以下是实现程序化数据获取和管理的几个技术要点:

编程语言:Python、Java、JavaScript等具有强大库支持的编程语言。

框架与库:Scrapy、Beautiful Soup(针对Python)、Spring Boot(针对Java)等用于爬虫和开发的框架和库。

数据库技术:MySQL、MongoDB、Redis等数据库技术用于数据存储和管理。

大数据处理:Hadoop、Spark等大数据处理技术用于处理大规模数据集。

数据安全与隐私:遵循GDPR或其他相关法规,确保数据处理过程的安全性和用户隐私保护。

实践案例分析

这里可以举一个具体案例,说明如何利用程序化方法获取某个行业中的“王中王资料大全料大全1”数据,包括数据的抓取、处理、分析和呈现等步骤。通过实际案例,可以让读者更加直观地了解数据获取方案的实际应用。

案例概述:某研究团队需要获取最新的经济数据以预测未来市场趋势。他们使用Python的Scrapy框架抓取世界银行提供的经济数据,并使用pandas进行数据处理和分析,最后使用matplotlib生成图表,直观展示数据趋势。

结论

程序化的数据获取和管理为信息的高效处理提供了可能。通过上述步骤和技术的运用,可以大大提高资料搜索和分析的效率,满足不同用户群体的需求。在实施程序化数据获取方案时,还需要注意法律和伦理问题,确保数据采集的合规性。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号